新騙局出現,詐騙成功率接近100%,大家一定要警惕,建議轉告家人

前言 人們常說「眼見為實,耳聽為虛」,可有些時候,親眼看到的也不一定是真的。

騙子們只需要一張照片,就能夠進行AI換臉,冒充你最親近的人實施詐騙手段。

這種詐騙手段的成功率高達100%,所以一定要對這件事情提高警惕,保護好自己和家人的安全。

AI詐騙 AI詐騙的觸角,已經從公眾人物延伸至普通民眾,其危害性日益加劇。

我們先來看一些觸目驚心的案例。

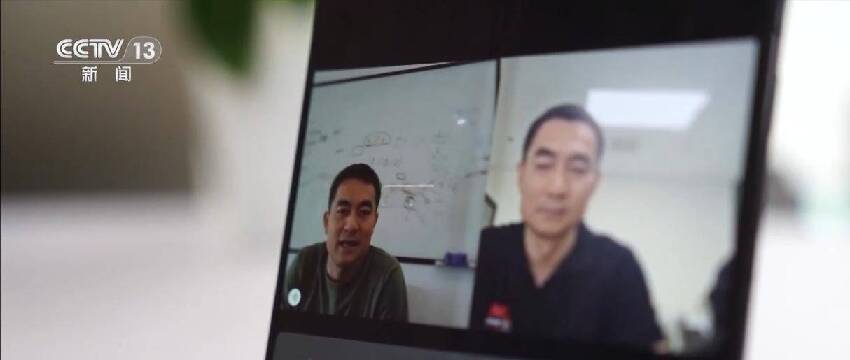

2023年5月,福州一位公司法人代表郭先生,就遭遇了一場精心策劃的AI詐騙。

他接到了一位「朋友」的微信視頻電話,對方不僅容貌與聲音都和他的朋友一模一樣,甚至還展示了所謂的競標現場。

郭先生信以為真,將430萬元轉入對方提供的賬戶,短短10分鐘內就損失慘重。

事後才發現,這通視頻電話完全是騙子利用AI技術偽造的。

另一個更常見的案例是,騙子冒充熟人,通過視頻通話要求轉賬,由於其逼真程度極高,成功率幾乎達到100%。

尤其對於辨別能力較弱的老年人來說,AI合成的聲音更是難以分辨,他們更容易落入騙子的圈套。

北京日報的調查顯示,參與測試的10位老人都無法準確分辨真人語音和AI合成語音,甚至聽到自己家人的AI合成聲音,也毫不懷疑地認為是真人。

這些案例僅僅是冰山一角,它們揭示了一個殘酷的現實:AI詐騙已經滲透到我們生活的方方面面,任何人都可能成為受害者。

AI詐騙的技術手段 AI詐騙之所以如此猖獗,與其背後精密的技術手段密不可分。

然而,再高明的技術也並非無懈可擊,了解這些技術手段及其漏洞,有助於我們提高警惕,識別騙局。

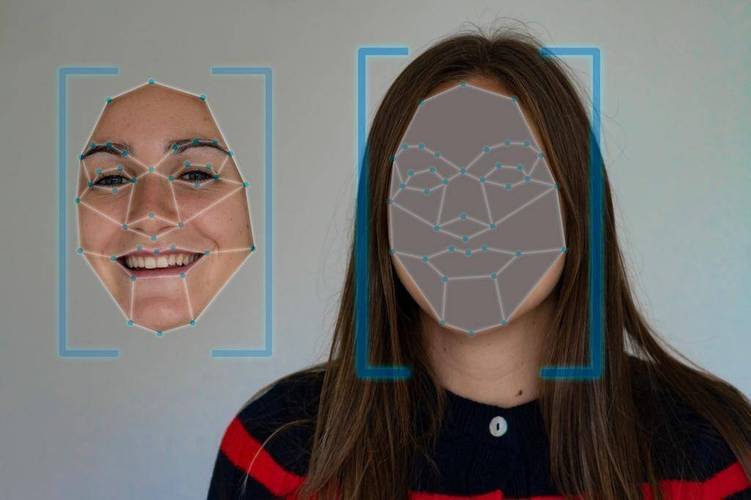

AI換臉技術是AI詐騙的核心手段之一。

它可以實時替換人臉,模仿任何人的面部表情和動作,進行視頻通話。

AI擬聲技術則可以模仿任何人的聲音,進行語音通話,其逼真程度足以以假亂真。

此外,AI還可以生成帶有時間、地點等細節的假新聞,並迅速傳播,讓人難以分辨真假。

這些技術手段的結合,使得AI詐騙更加難以防範。

儘管AI技術日新月異,但其生成的視頻和語音並非完美無缺。

仔細觀察,仍能發現一些蛛絲馬跡。

例如,在視頻通話中,偽造人物的眼睛和瞳孔細節往往不一致,嘴部動作也無法完全匹配語音。